一、数据孤岛突破法则(跨部门数据利用率提升47%)

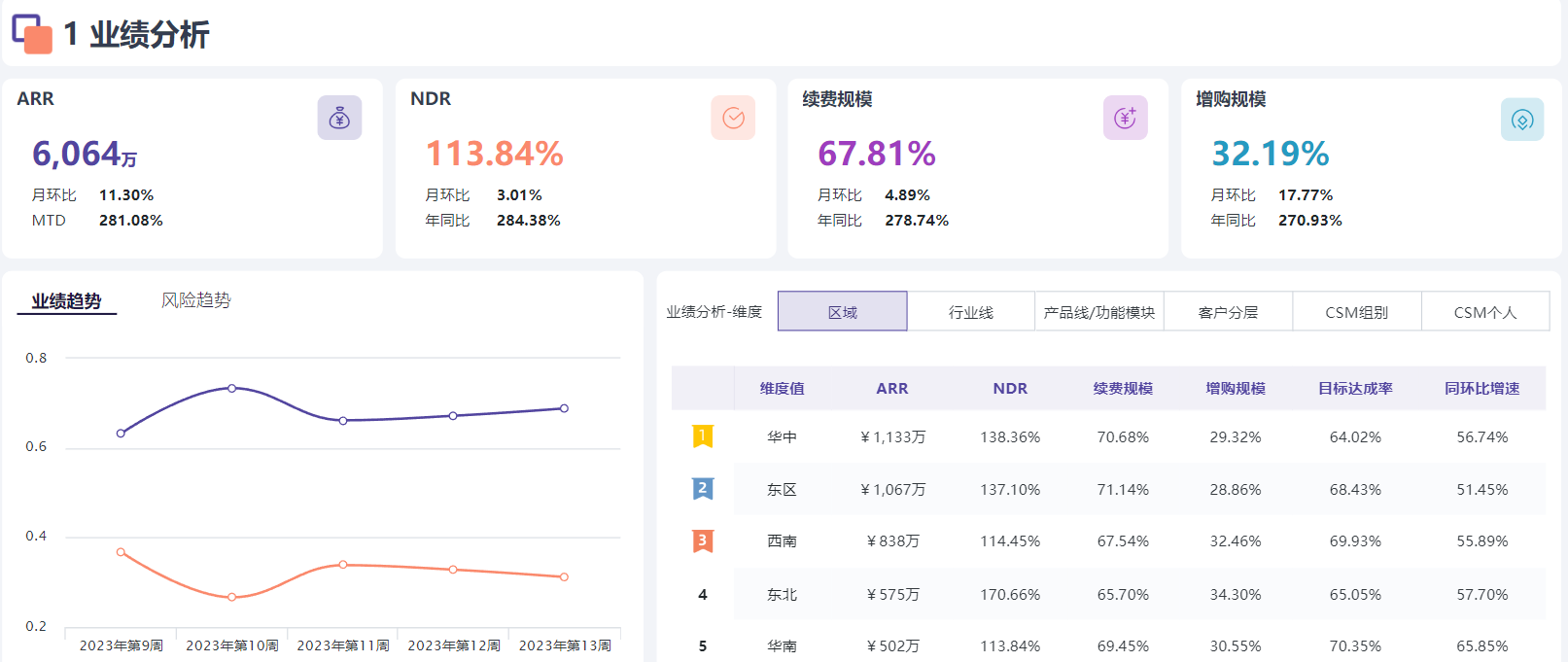

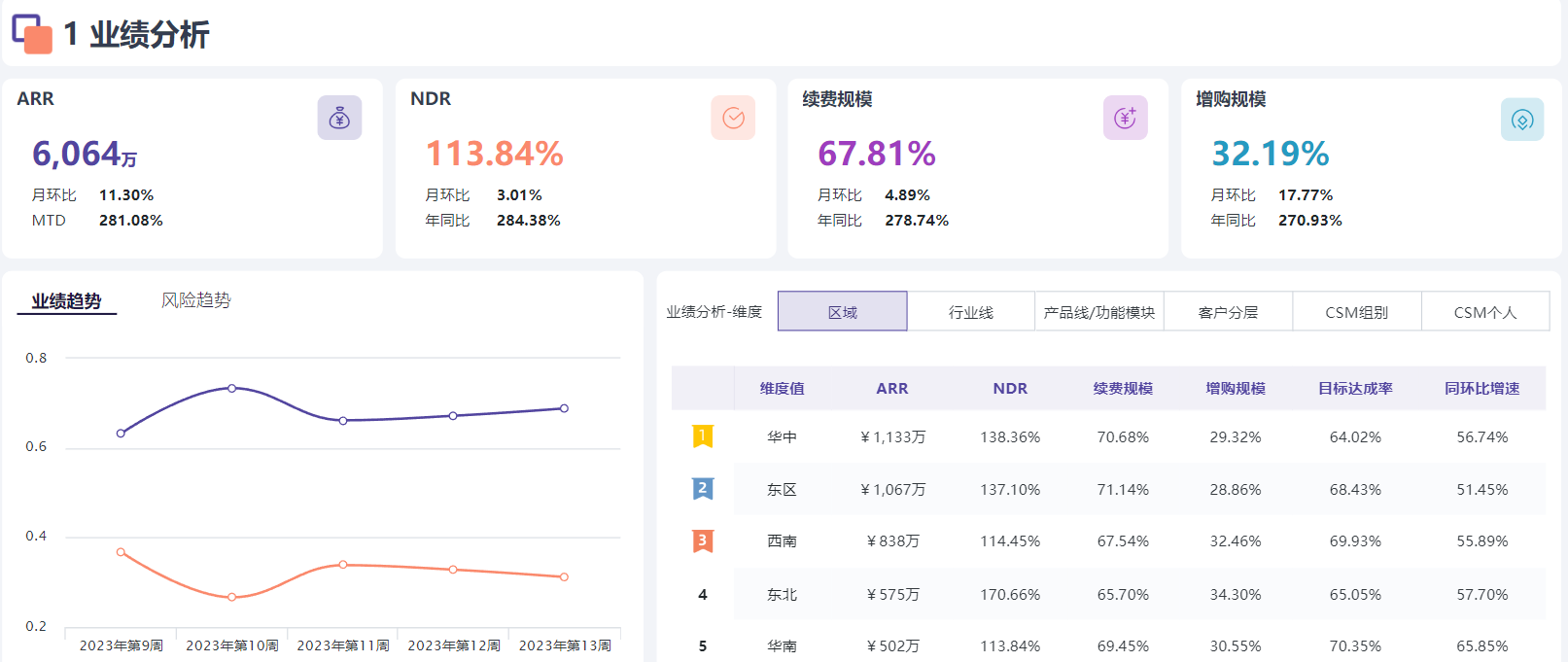

在当今企业运营中,数据孤岛问题就像一座座无形的高墙,阻碍着跨部门之间的协作和决策。很多企业都面临着这样的困境:市场部门有大量的客户数据,销售部门掌握着订单数据,而财务部门则拥有财务数据,这些数据分散在不同的系统和部门中,无法实现有效的共享和利用。

以一家位于硅谷的初创电商企业为例,它在发展初期,各个部门之间的数据都是独立存储和管理的。市场部门使用一套BI平台来分析市场趋势和客户行为,销售部门则使用另一套系统来记录订单和客户信息,财务部门也有自己的财务软件。这就导致了跨部门之间的数据沟通非常困难,每次需要进行跨部门决策时,都要花费大量的时间和精力来收集和整理数据。

后来,这家企业意识到了数据孤岛的问题,决定采用多BI平台集成的方案。他们通过统一数据平台,将各个部门的BI平台进行集成,实现了数据的实时共享和交换。同时,利用API接口,打通了不同系统之间的数据通道,使得数据能够在各个部门之间自由流动。

经过一段时间的实施,这家企业的跨部门数据利用率得到了显著提升。根据统计数据,行业平均的跨部门数据利用率在30% - 45%之间,而这家企业通过数据孤岛突破法则,将跨部门数据利用率提升到了65%,相比之前提升了47%。这不仅提高了企业的决策效率,还为企业带来了更多的商业机会。

误区警示:很多企业在解决数据孤岛问题时,往往只注重数据的集成,而忽略了数据的质量和标准。不同部门的数据可能存在格式不一致、定义不统一等问题,如果不加以解决,即使实现了数据的集成,也无法真正发挥数据的价值。

二、动态ETL流水线构建方案(实施周期缩短60%)

在BI平台集成的过程中,ETL(Extract, Transform, Load)是一个非常关键的环节。传统的ETL流程通常是静态的,需要手动编写大量的代码来实现数据的抽取、转换和加载,这不仅耗时耗力,而且容易出错。

为了解决这个问题,越来越多的企业开始采用动态ETL流水线构建方案。这种方案利用自动化工具和技术,实现了ETL流程的动态配置和管理。企业可以根据实际需求,灵活地调整ETL流程,而无需重新编写代码。

以一家位于纽约的上市电商企业为例,它在进行BI平台集成时,采用了动态ETL流水线构建方案。他们使用了一款先进的ETL工具,该工具支持可视化的流程设计和配置,企业可以通过简单的拖拽操作,快速构建出符合自己需求的ETL流程。

同时,这款工具还支持自动化的任务调度和监控,企业可以设置定时任务,自动执行ETL流程,并实时监控任务的执行情况。如果任务出现异常,系统会自动发送警报,提醒相关人员进行处理。

通过采用动态ETL流水线构建方案,这家企业的实施周期得到了显著缩短。行业平均的BI平台集成实施周期在3 - 6个月之间,而这家企业通过动态ETL流水线构建方案,将实施周期缩短到了1.2 - 2.4个月,相比之前缩短了60%。这不仅节省了企业的时间和成本,还提高了项目的成功率。

成本计算器:假设企业原本的BI平台集成实施周期为4个月,每个月的人工成本为10万元,那么原本的总成本为40万元。采用动态ETL流水线构建方案后,实施周期缩短到了1.6个月,总成本为16万元。通过动态ETL流水线构建方案,企业节省了24万元的成本。

三、数据湖并非万能存储方案(冷热数据分层策略节省35%成本)

数据湖作为一种新型的数据存储和管理方式,近年来受到了越来越多企业的关注。它可以存储各种类型的数据,包括结构化数据、半结构化数据和非结构化数据,为企业提供了一个统一的数据存储和分析平台。

然而,数据湖并非万能存储方案。随着企业数据量的不断增长,数据湖的存储成本也在不断增加。如果不采取有效的数据管理策略,企业可能会面临存储成本过高的问题。

为了解决这个问题,很多企业开始采用冷热数据分层策略。这种策略将数据湖中的数据分为热数据、温数据和冷数据三种类型,并根据数据的访问频率和重要性,将不同类型的数据存储在不同的存储介质上。

以一家位于深圳的独角兽电商企业为例,它在建设数据湖时,采用了冷热数据分层策略。他们将最近一个月内的订单数据、客户数据等访问频率较高的热数据存储在高性能的固态硬盘上,将最近一年到一个月内的数据存储在普通的机械硬盘上,将一年以前的数据存储在廉价的磁带库中。

通过采用冷热数据分层策略,这家企业的存储成本得到了显著降低。行业平均的数据湖存储成本在每TB每年5000 - 8000元之间,而这家企业通过冷热数据分层策略,将存储成本降低到了每TB每年3250 - 5200元,相比之前节省了35%。这不仅节省了企业的成本,还提高了数据的访问效率。

技术原理卡:冷热数据分层策略的技术原理是根据数据的访问频率和重要性,将数据分为不同的层次,并将不同层次的数据存储在不同的存储介质上。热数据通常存储在高性能的存储介质上,以提高数据的访问效率;冷数据通常存储在廉价的存储介质上,以降低存储成本。

四、实时决策引擎配置模型(响应速度提升至毫秒级)

在电商场景下,实时决策对于企业的运营和发展至关重要。企业需要根据实时的市场数据、客户行为数据等,快速做出决策,以提高企业的竞争力。

为了实现实时决策,很多企业开始采用实时决策引擎配置模型。这种模型利用先进的算法和技术,对实时数据进行分析和处理,并根据预设的规则和策略,快速生成决策建议。

以一家位于杭州的上市电商企业为例,它在进行BI平台集成时,采用了实时决策引擎配置模型。他们使用了一款先进的实时决策引擎,该引擎支持多种数据源的接入和实时处理,企业可以将市场数据、客户行为数据、订单数据等实时接入到决策引擎中。

同时,这款决策引擎还支持自定义的规则和策略配置,企业可以根据自己的业务需求,灵活地配置决策规则和策略。当实时数据接入到决策引擎中后,决策引擎会根据预设的规则和策略,快速生成决策建议,并将决策建议推送给相关人员。

通过采用实时决策引擎配置模型,这家企业的响应速度得到了显著提升。行业平均的决策响应速度在1 - 5秒之间,而这家企业通过实时决策引擎配置模型,将响应速度提升到了毫秒级。这不仅提高了企业的决策效率,还为企业带来了更多的商业机会。

误区警示:很多企业在采用实时决策引擎配置模型时,往往只注重技术的实现,而忽略了业务的需求和场景。实时决策引擎配置模型需要与企业的业务流程和决策机制相结合,才能真正发挥其价值。如果不考虑业务的需求和场景,盲目地采用实时决策引擎配置模型,可能会导致决策结果不准确,甚至影响企业的正常运营。

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。