我观察到一个现象,很多企业在BI工具上的投入越来越大,从采购昂贵的软件到组建专门的数据分析团队,预算动辄百万。但奇怪的是,当我问他们“这笔钱花得值吗?”的时候,很多人却答不上来。问题就出在这里:大家往往只盯着BI报表的“面子”——那些酷炫的可视化看板,却忽略了藏在冰山下的“里子”——那些巨大的、看不见的沉默成本。说白了,如果不能从成本效益的角度去审视BI,那么再强大的工具也可能变成一个烧钱的无底洞。今天我们就来聊聊,如何避开这些陷阱,让每一分钱的数据投入都产生真正的商业决策价值。

一、可视化看板的决策毒药:为何投入巨大却收效甚微?

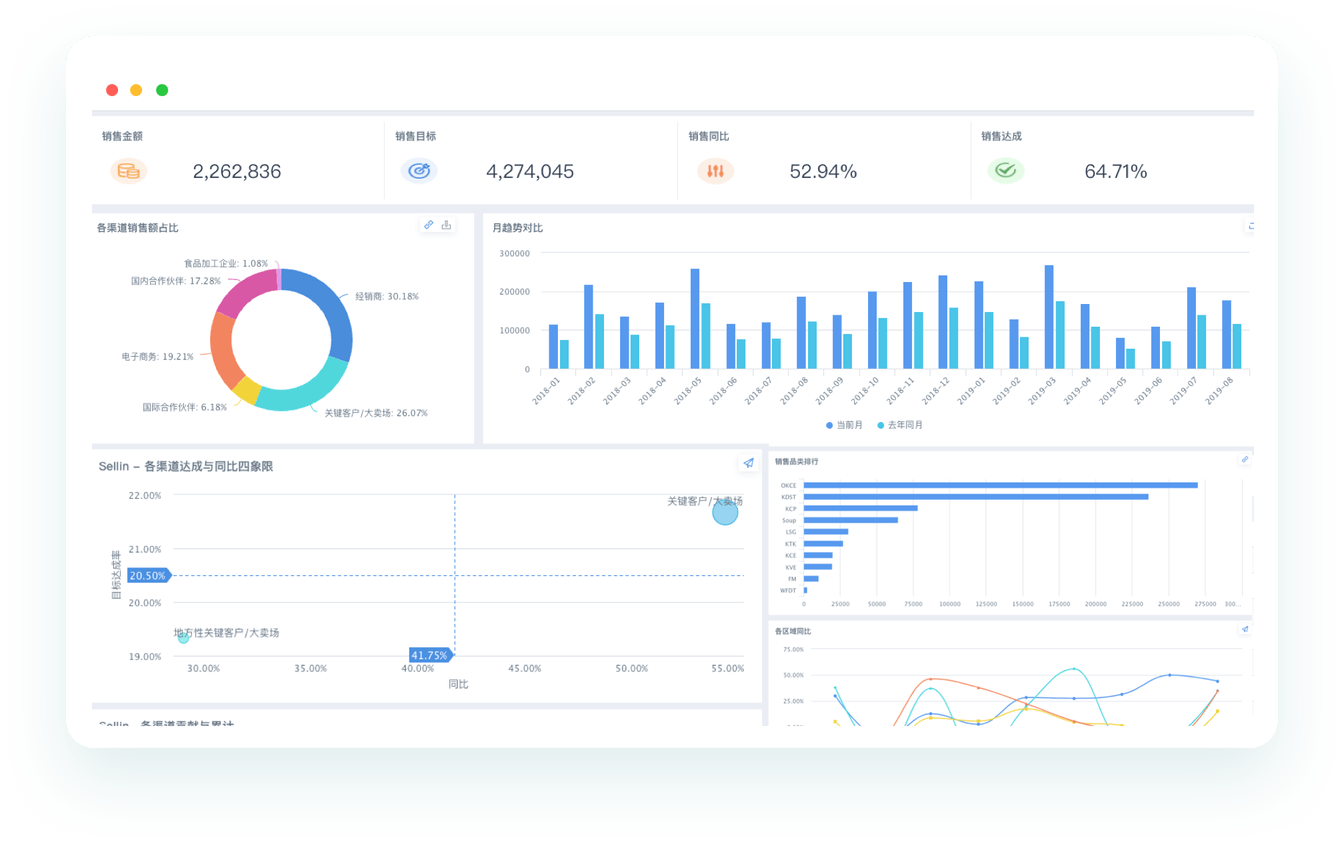

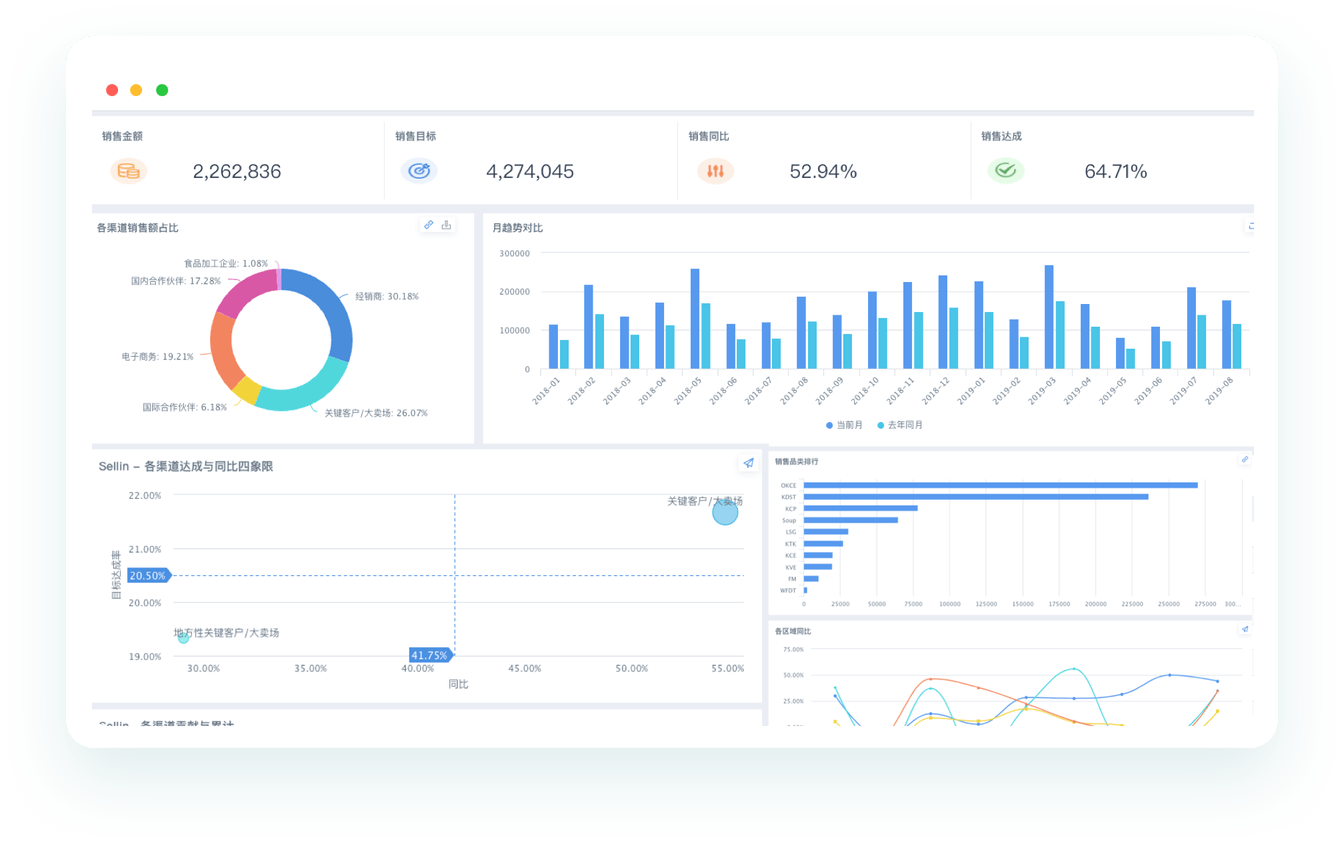

很多管理者对BI的初步认知,就来自于那些在大屏幕上滚动播放、色彩斑斓的可视化看板。它看起来很“性感”,象征着公司的数字化水平。但一个常见的痛点是,这些看板往往沦为“面子工程”,投入巨大,实际带来的业务价值却微乎其微。这背后的成本账,远比想象中复杂。首先是直接成本,开发和维护一个定制化的复杂看板,需要前端、后端、数据工程师的协同工作,人力成本高昂。更深一层看,真正的“毒药”是机会成本和决策误导成本。我见过太多公司,看板上堆砌了几十个指标,五颜六色,但一线业务人员看完后,唯一的感受是“哦,知道了”,然后继续按老办法工作。为什么?因为这些指标与他们的日常决策和KPI无关,无法指导下一步行动。这就是典型的“有数据,无洞察”。一个常见的BI报表常见误区就是,认为图表越炫酷,数据价值就越高,这完全是本末倒置。真正有效的看板,应该是简洁的、与业务行动强相关的。在考虑如何选择合适的BI工具时,不应只看其可视化能力,更要评估它将数据转化为行动指令的效率。

### 成本计算器:单一可视化看板的年度总成本(TCO)估算

这个模块可以帮助你估算维护一个看似简单的看板背后,一年需要投入多少隐性成本。

- 人力成本:假设需要0.2名数据工程师(负责数据管道)、0.2名前端工程师(负责页面优化)和0.1名产品经理(负责需求沟通),按人均年包50万计算,年度人力成本为 (0.2 + 0.2 + 0.1) * 50万 = 25万元。

- 服务器/云资源成本:为保证数据抽取和前端展示的流畅度,每月云资源费用约2000元,年度成本为 2000 * 12 = 2.4万元。

- 软件摊销成本:如果使用了商业BI软件,单个看板可能还需分摊部门级的软件许可费用,假设每年1万元。

- 机会成本:如果团队花时间维护这个低效看板,而没有去做更高价值的数据分析项目,这个成本难以量化但真实存在。

说白了,一个看似“漂亮”的看板,一年烧掉30万成本是家常便饭。如果它不能驱动哪怕一个能带来30万以上收益的决策,那它就是一笔净亏损的投资。

二、数据清洗的ROI倍增公式:如何衡量这笔“看不见”的投入?

说到BI报表,很多人时间想到的是分析和可视化,但往往忽略了最前端也最耗时的工作——数据清洗。很多人的误区在于,把数据清洗看作是一个纯粹的“成本中心”,是技术人员干的脏活累活,能省则省。但换个角度看,高质量的数据清洗恰恰是整个数据分析链路中ROI(投资回报率)最高的一环。为什么这么说?因为“垃圾进,垃圾出”(Garbage In, Garbage Out)。一个基于错误或不完整数据做出的决策,其破坏力可能远超你的想象。比如,一个电商公司因为用户地址数据不干净,导致10%的营销物料投递失败,这不仅浪费了物料和物流成本,更损失了潜在的销售机会。这笔账,必须算清楚。我们可以把数据清洗的ROI看作一个公式:ROI = (避免的损失 + 创造的增益) / 清洗的成本。避免的损失包括错误的广告投放、失败的营销活动、无效的客户触达等。创造的增益则来自更精准的用户画像、更高的转化率和更科学的库存管理。不仅如此,干净的数据还能大幅提升数据分析师的工作效率,让他们把更多时间花在探索洞察上,而不是日复一日地“整理表格”。

### 案例分析:数据清洗如何提升营销ROI

以一家位于杭州的初创SaaS公司为例,他们发现其线上广告的线索转化率持续低迷。最初以为是广告创意或落地页的问题,但在深入分析后,发现源头在于CRM系统中有大量重复、错误和过时的销售线索数据。这些“脏数据”导致销售团队将大量时间浪费在无效跟进上。后来,他们投入约5万元成本,引入自动化数据清洗工具并建立了一套标准流程。三个月后,效果立竿见影。

| 评估维度 | 清洗前 | 清洗后 | 成本效益分析 |

|---|

| 有效线索占比 | 65% | 92% | 销售效率大幅提升 |

| 单线索跟进成本 | 80元 | 58元 | 无效沟通成本降低27.5% |

| 最终签约转化率 | 1.2% | 2.5% | 收入直接翻倍增长 |

这个案例清楚地表明,投资于数据清洗,是撬动整个业务增长的关键杠杆,其回报远高于其成本。

三、指标拆解的20%关键因子法则:怎样用最少的精力找到增长引擎?

在BI报表和数据分析的世界里,“少即是多”是一个黄金法则。我见过很多公司的BI看板,密密麻麻罗列了上百个指标,从网站PV、UV,到每个按钮的点击率,看似面面俱俱到,实则眉毛胡子一把抓,反而迷失了方向。这背后是巨大的精力成本和时间成本。每个指标的计算、监控和维护都需要资源,当团队被无数个次要指标牵着鼻子走,他们就失去了聚焦于核心问题的能力。更深一层看,这就是典型的“指标陷阱”。为了避免陷入其中,我们需要运用“20%关键因子法则”,也就是我们常说的二八定律。在任何一个商业模式中,通常只有20%的关键指标(我们称之为“北极星指标”及其核心驱动指标)决定了80%的业务成果。指标拆解的核心任务,就是从海量数据中,把这20%的“关键因子”识别并剥离出来。例如,对于一个SaaS产品,与其每天盯着官网访问量,不如把“用户活跃度”或“客户留存率”作为北极星指标,然后向下拆解,找到影响活跃和留存的关键行为,比如“用户是否完成了核心功能A”、“用户是否邀请了新成员”等。把这些关键行为指标做到BI报表里,才能让数据真正服务于增长决策。

### 误区警示:虚荣指标 vs. 行动指标

很多团队痴迷于“虚荣指标”(Vanity Metrics),这些指标看起来很美,但无法指导行动,反而会带来误判,浪费大量营销和产品研发成本。

- 虚荣指标的例子:累计注册用户数、网站总点击量、社交媒体粉丝数。这些数字很容易增长,能让团队感觉良好,但与业务的核心健康度关联不大。

- 行动指标的例子:新用户的次周留存率、付费用户转化率、单个客户生命周期价值(LTV)。这些指标直接反映了产品是否对用户有价值,以及商业模式是否可持续。

在构建BI报表时,必须毫不留情地砍掉那些只会带来虚假繁荣的虚荣指标。每一次指标拆解,都应该问自己一个问题:“这个指标的波动,会直接改变我们下周的工作计划吗?”如果答案是否定的,那它大概率就是一个需要被优化的指标。将精力聚焦于20%的关键指标,是实现低成本、高效率数据驱动决策的不二法门。

四、BI报表的沉默成本陷阱:除了软件采购费,你还忽略了哪些开销?

谈到BI的成本,大部分人首先想到的是软件采购费。无论是订阅SaaS服务,还是购买本地化部署的许可证,这笔钱确实很显眼。但一个残酷的现实是,这笔采购费可能只占到BI项目总拥有成本(TCO)的20%-30%。更多、更庞大的成本,是那些隐藏在水面之下的“沉默成本”,它们日复一日地侵蚀着你的预算和团队精力。个沉默成本是“集成与定制开发成本”。很少有BI工具能做到开箱即用,你需要投入工程师资源,将其与公司现有的数据库、CRM、ERP等系统打通。如果业务需求特殊,还需要进行大量的二次开发。第二个是“培训与学习成本”。再好的工具,如果业务团队不会用、不想用,那它的价值就是零。组织培训、编写教程、以及员工在学习过程中付出的时间,都是实打实的成本。我见过一个案例,一家上市零售企业花重金引入一套国外顶级的BI系统,但因为界面复杂、学习曲线陡峭,一线店长和区域经理的采用率不足10%,最终这套昂贵的系统成了一个摆设。这就是最大的成本浪费。第三个是“运维与支持成本”。系统需要维护、数据需要治理、用户遇到的问题需要有人解答。这些都需要持续的人力投入。因此,在评估为什么需要BI报表以及如何选择合适的BI工具时,绝不能只盯着报价单,而应该画一张完整的成本地图。

### 案例:某中型电商企业BI系统年度总拥有成本(TCO)估算

| 成本项目 | 年度费用估算(万元) | 占总成本比例 | 说明 |

|---|

| 软件年度订阅费 | 30 | 27.3% | 显性成本,容易被关注 |

| 集成与开发人力 | 40 | 36.4% | 1名数据工程师+0.5名后端工程师 |

| 员工培训与推广 | 15 | 13.6% | 包括组织培训、制作材料和员工时间成本 |

| 运维与技术支持 | 25 | 22.7% | 0.5名运维/数据分析师负责 |

| 年度总成本 | 110 | 100% | 软件费占比不到三成 |

从这张表可以清晰地看到,沉默成本是显性成本的2-3倍。如果不把这些账算清楚,你的BI项目很可能从一开始就走在了一条通往“亏损”的路上。

五、实时数据的行动延迟效应:你的“快”数据真的带来了高效率吗?

“实时数据”是近几年被炒得非常火热的概念。很多技术供应商会告诉你,拥有实时数据看板,你就能在瞬息万变的市场中占尽先机。这听起来非常诱人,但从成本效益的角度来看,追求极致的“实时”可能是一个昂贵的陷阱。实现真正意义上的实时数据处理(流处理),需要复杂的技术架构和高昂的服务器资源成本,比传统的批量处理(T+1)要贵上好几个数量级。问题是,你的业务真的需要为这份“快”买单吗?这里就引出了一个概念,我称之为“行动延迟效应”。说白了,就是即便数据以毫秒级的速度更新在你的BI报表上,但如果你的团队、你的业务流程,无法以同样的速度做出反应和调整,那么这份“实时”的价值就大打折扣。比如,一个电商的销售月报,数据实时更新并不会改变什么,因为复盘和决策是以月为单位进行的。在这种场景下,投入巨资做实时报表,就是典型的资源浪费。但换个场景,比如在线交易的风险监控或欺诈检测,数据晚到一秒钟都可能造成巨大损失,那么为实时性投入再多成本都是值得的。因此,在思考为什么需要BI报表时,关键不是一味追求“快”,而是要让数据的时效性与业务决策的节奏相匹配。对大部分管理和运营决策而言,“准实时”(如每小时更新)或“T+1”已经足够,并且成本效益要高得多。

### 技术原理卡:批量处理 vs. 实时处理的成本差异

- 批量处理 (Batch Processing):

- 原理:将数据积累到一定量(比如一天),然后一次性进行处理和计算。典型的例子是T+1报表。

- 技术栈:相对简单,常用Hadoop MapReduce, Spark Batch等。

- 成本:计算资源是按需、分时使用的,总体成本较低。适合对时效性要求不高的分析场景。

- 实时处理 (Stream Processing):

- 原理:数据像水流一样,来一条就处理一条,结果可以做到秒级甚至毫秒级更新。

- 技术栈:更为复杂,常用Flink, Spark Streaming, Storm等。需要7x24小时运行的集群。

- 成本:服务器和运维成本非常高昂,因为计算资源需要持续在线待命。适合风控、实时推荐等对时效性要求极致的场景。

总而言之,不要为了“实时”而“实时”。在选择技术方案前,先算清楚这笔ROI账:为了将数据更新速度从一天缩短到一分钟,你需要多付出10倍的成本,而这个“快”,到底能为你的业务带来多少额外的收益?想清楚这个问题,能帮你省下一大笔冤枉钱。本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。