我观察到一个现象,很多企业投入巨资构建数据报表系统,最终却发现决策效率和成本效益并不成正比。说白了,报表是做了不少,但大多是“无效报表”,不仅没能辅助企业决策支持,反而成了IT和业务部门的沉重负担。一个常见的痛点是,大家把焦点放在了数据可视化工具的技术实现上,却忽略了报表运营的本质——以最低的成本,撬动最高的决策价值。今天,我们就从成本效益的角度,聊聊如何有效运营报表,以及那些常见的报表设计误区是如何让你白花钱的。

一、如何纠正决策层的数据认知偏差?

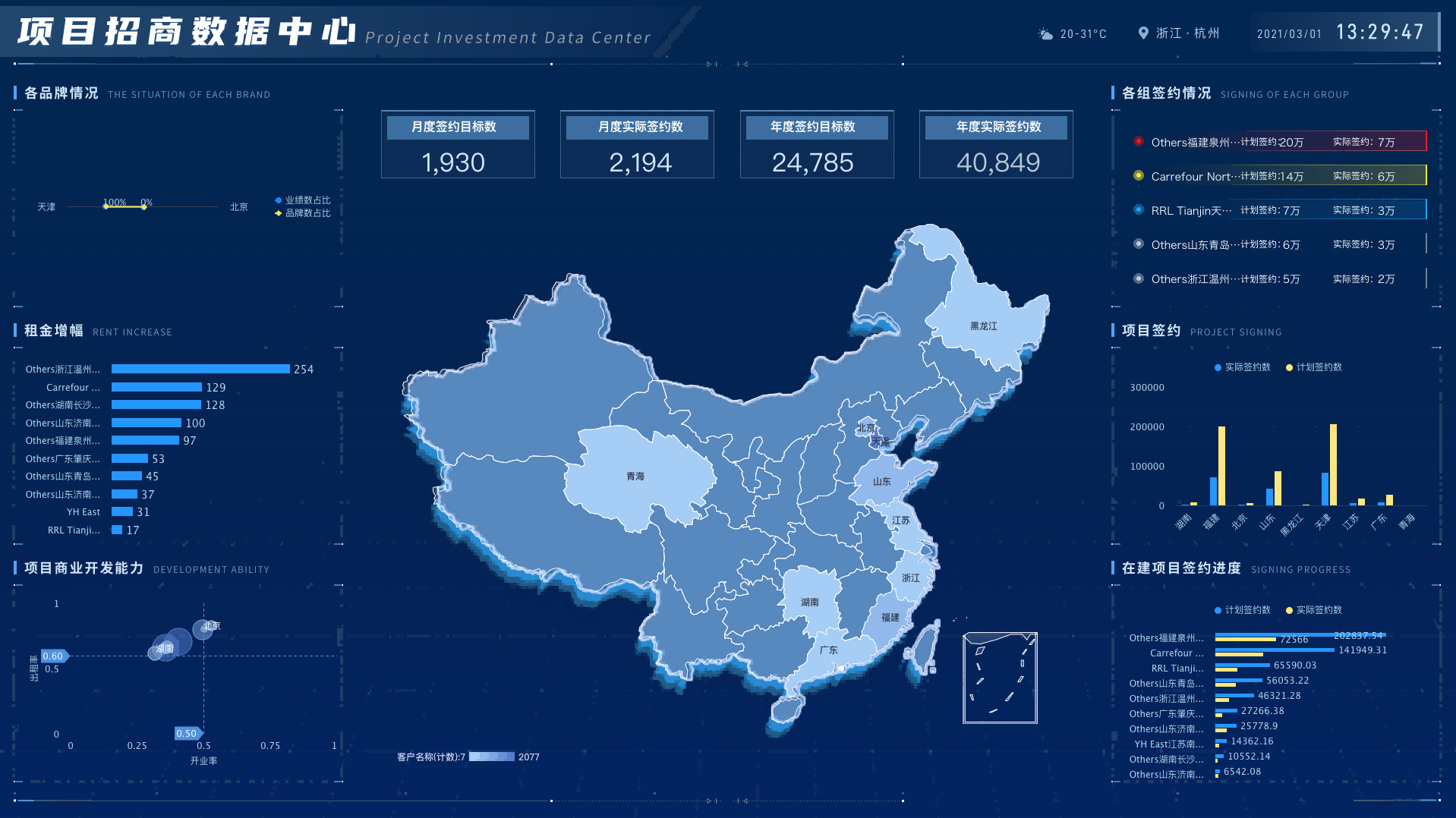

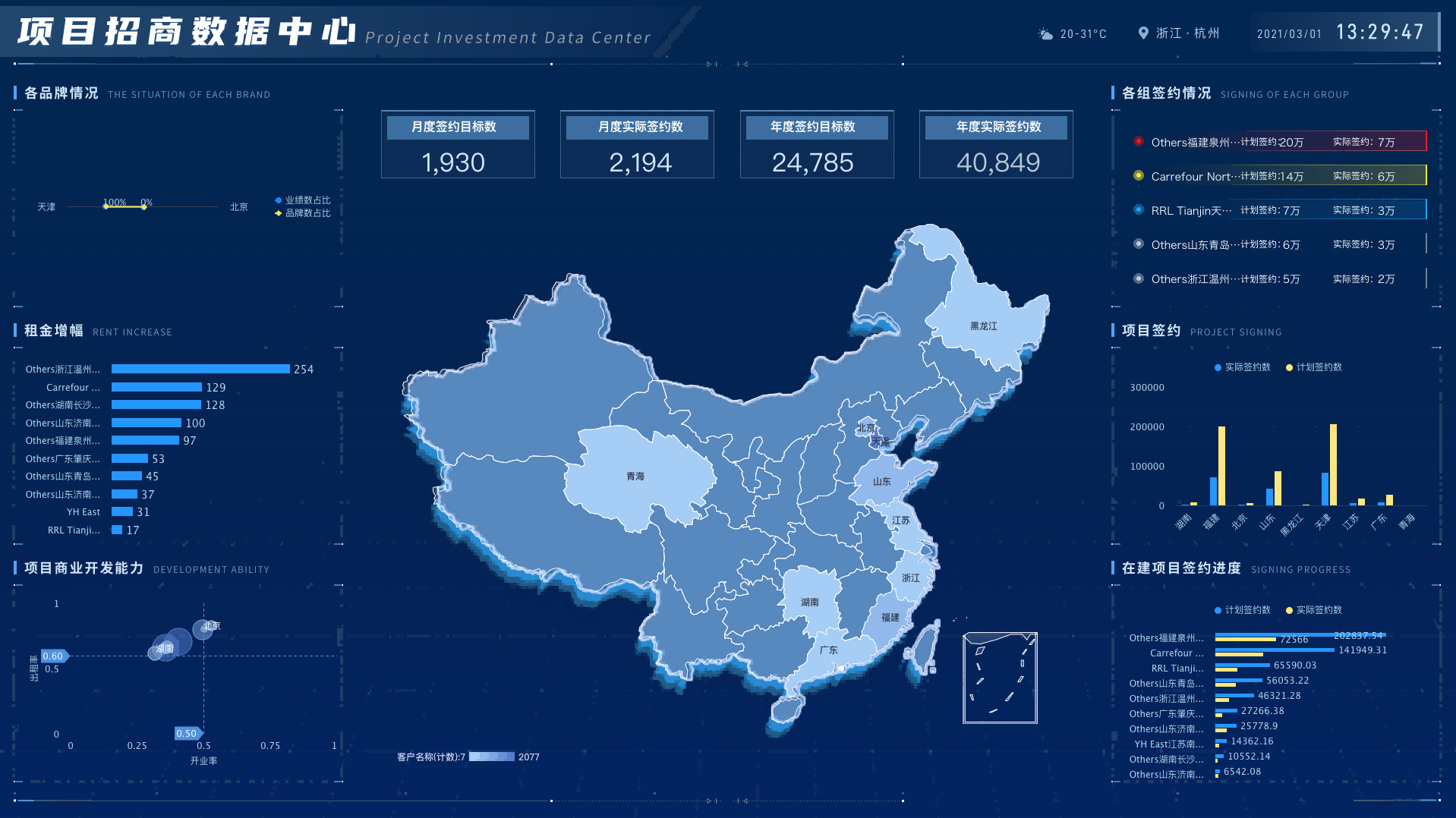

很多人的误区在于,认为报表是给老板看的,老板要什么就给什么。这恰恰是成本失控的开始。决策层的数据认知偏差,是报表系统里最昂贵的“Bug”。比如,老板可能偏爱宏观的、看起来很“战略”的“驾驶舱”大屏,上面堆满了各种酷炫但关联性不强的KPI。为了实现这个大屏,技术团队可能需要花费数百小时整合数据、开发接口、调试图表,但最终它沦为办公室的“装饰品”,实际决策价值微乎其乎。这种需求,本质上是把报表当成了“面子工程”,而不是生产力工具。

换个角度看,有效的报表需求分析,其重要性就在于敢于向上管理。一个优秀的报表工程师或产品经理,需要引导决策者思考:“这个数据能指导你做出什么具体行动?”、“如果这个指标上升或下降了,我们的应对策略是什么?”。通过这种方式,将模糊的“看一看”需求,转化为明确的、可行动的分析型需求。这不仅能砍掉大量无效的开发工作,节省直接的人力成本,更能避免基于“感觉良好”的指标做出错误决策,从而规避了巨大的机会成本。说到底,纠正认知偏差的成本,远低于一个错误战略决策带来的损失。

.png)

更深一层看,这种偏差的持续存在,会让数据团队的价值感越来越低,陷入“做表工具人”的循环,最终导致高价值人才流失,这又是另一笔高昂的隐性成本。因此,建立一套从需求提出到价值评估的闭环流程,至关重要。

成本计算器:无效“面子工程”报表的真实成本

| 成本项 | 描述 | 估算成本 |

|---|

| 直接开发成本 | 2名工程师,耗时3周进行数据整合与前端开发 | ¥120,000 |

| 持续维护成本 | 每月数据源变更、Bug修复等,约占0.5人力 | ¥20,000/月 |

| 机会成本 | 因关注虚荣指标,忽略了核心用户流失率预警,导致一个季度后用户流失增加5% | ¥500,000+ |

| 总计隐形成本 | 开发团队因“价值感低”导致核心成员离职的招聘与培训成本 | 无法估量 |

二、动态数据建模的黄金比例是什么?

说到这个,很多技术团队容易陷入一个“完美主义”陷阱。他们追求建立一个无所不包、极度灵活的动态数据模型,理论上用户可以任意拖拽、组合、下钻所有维度。听起来很美好,但从成本效益角度看,这往往是一场灾难。为什么?因为过度设计的模型开发周期极长,维护成本高到惊人,而且性能通常很差。一个查询可能要跑几分钟,用户早就失去耐心了。这种“屠龙之技”最终没人用,前期的巨大投入等于打了水漂。

反之,另一个极端是完全依赖固化报表。开发快,成本低,但业务方每需要一个新维度、新视角,都得找IT排期,响应速度极慢,完全跟不上市场变化。这在经营分析报告策划中是致命的。那么,黄金比例究竟在哪?我观察到的成功实践,通常遵循“80/20”原则。即:针对80%高频、固定的分析场景,提供性能最优的固化报表或轻度下钻的聚合模型。这部分报表响应速度快、开发和维护成本可控,满足了日常运营监控的大部分需求。对于剩下20%探索性、低频的复杂分析需求,才提供一个相对灵活的、基于底层明细数据的动态查询模型。用户在使用这部分功能时,也明确知道这是“重型武器”,对性能有合理预期。

不仅如此,这种分层设计还能极大地降低数据治理的成本。固化报表的数据口径是统一且锁定的,保证了全公司对核心指标理解的一致性。而探索性分析则被限制在特定范围内,避免了“数据口径满天飞”的混乱局面。说白了,动态数据建模的黄金比例,不是一个技术问题,而是一个基于成本和业务价值的资源分配策略。

三、如何实践敏捷报表的迭代方程式?

一个常见的报表开发流程是:业务提需求,IT花一两个月开发,上线后发现跟业务想象的不一样,或者业务场景已经变了。这种“瀑布式”开发模式,在快速变化的市场环境中,成本和风险都极高。每一轮修改都是新一轮的成本投入,最终交付的报表很可能已经“过时”。敏捷报表的迭代方程式,就是要打破这个僵局,其核心是:最小可用产品(MVP)+ 快速迭代 + 用户反馈。

说白了,就是别想着一次性做出完美的报表。步,用最短的时间(比如一周)做出一个最简陋但能跑通核心逻辑的版本。可能没有酷炫的图表,甚至只是一个数据表格,但它能验证这个数据指标是否有价值。然后,把这个MVP版本直接交给最终用户,让他们在实际工作中用起来,并收集反馈:“这个数据对你有用吗?”、“你还希望看到什么关联数据?”、“这个图表的呈现方式清晰吗?”。这种贴近实战的反馈,远比关在会议室里空想要精准得多。

换个角度看,敏捷迭代的成本优势是指数级的。传统模式下,一个需求从提出到交付,总成本可能是 C = C1(开发) + C2(修改) + C3(再修改)... 每次修改的成本都不低。而在敏捷模式下,总成本 C' = c1(MVP) + c2(迭代) + c3(迭代)... 每次迭代的成本 c 都很小,而且方向始终在被用户反馈校准,几乎没有“冤枉钱”。更重要的是,价值交付周期大大缩短。传统模式可能3个月后才看到结果,敏捷模式下,一周后就能产生初步价值。这种模式尤其适合初创企业和需要快速响应市场的业务团队。

误区警示:敏捷不是“没有规划”

很多人把“敏捷”误解为“走一步看一步”,这是极大的错误。敏捷报表的背后,需要一个更强大的数据底层和架构支持。数据仓库的规范性、数据接口的标准化、ETL流程的稳定性,都是实现快速迭代的基础。如果底层数据一团糟,每次迭代都需要从源头“刨数据”,那敏捷就无从谈起。敏捷的“快”,是建立在后端“慢功夫”之上的,这一点在进行企业决策支持系统规划时必须明确。

四、非结构化数据的价值转化率如何提升?

我观察到一个现象,绝大多数企业的报表系统,处理的都是结构化数据——ERP的销售额、CRM的客户数、网站的点击量。这些固然重要,但往往忽略了一座巨大的金矿:非结构化数据。比如,客服工单里的客户抱怨、社交媒体上的产品评价、销售拜访记录里的客户原话。这些数据包含了最真实、最生动的用户痛点和市场信号。但为什么它们常常被忽视?核心原因就是处理成本高,价值难以量化。

提升非结构化数据的价值转化率,关键在于找到低成本的分析技术和高价值的应用场景。比如,利用自然语言处理(NLP)技术对客服工单进行情感分析和关键词提取,成本远低于人工阅读所有工单。你可以快速得到一个“本周产品功能吐槽TOP5”的报表,这对于产品迭代的优先级排序,价值千金。同样,分析社交媒体上的用户评论,可以帮你发现新的市场趋势或竞争对手的动态,这种情报的价值,用钱都很难买到。

说白了,要提升转化率,就不能把非结构化数据当成一个独立的技术项目来做,而是要把它融入到现有的业务决策流程中。比如,在看“用户流失率”这张报表时,能不能联动展示近期流失用户的“负面评论关键词”?在看“市场活动效果”报表时,能不能结合社交媒体上关于这次活动的“声量和情感趋势”?这种结合,让冰冷的数字有了温度和背景,决策者能看到的不再仅仅是“是什么”,更是“为什么”。从成本角度看,盘活这些“沉睡”数据的投入,相比于获取同等价值的外部市场调研报告,性价比极高。

技术原理卡:利用NLP进行工单情感分析

- 技术名称: 自然语言处理(NLP)情感分析模型

- 实现原理: 通过机器学习算法(如BERT模型),让计算机“阅读”文本,并判断其表达的情感是积极、消极还是中性。模型会学习大量的标注数据,从而识别出文本中的情感词、否定词、转折词等复杂语言现象。

- 成本效益分析: 一名人工阅读并标记1000条工单可能需要8小时,而机器处理仅需几分钟。投入在于初期的模型训练或调用云服务API的费用,但一旦系统建成,边际成本极低。它可以7x24小时不间断工作,实时发现潜在的客户投诉爆发点,为公关和客服团队争取宝贵的响应时间,避免事态升级带来的巨大损失。

五、可视化陷阱的边际成本有多高?

一个常见的报表设计误区是,过度追求图表的“美观”和“炫酷”,而忽视了信息传达的准确性。这就是可视化陷阱。比如,用3D饼图来展示市场份额,看起来立体,但由于透视效应,远端的块会显得比近端的小,造成视觉误判。再比如,为了让增长曲线看起来更“陡峭”,刻意截断Y轴的起点,不从0开始,这会极大地夸大增长率。这些看似微小的设计瑕疵,其边际成本可能高得惊人。

换个角度看,一张报表的成本,不仅仅是开发的工时,更包含了使用这张报表所做决策的风险成本。如果一张错误的图表,导致管理层对市场份额做出错误判断,从而将资源错误地投向一个实际上并不占优的市场,这个决策的损失可能是数百万甚至上千万。而修正这张图表的设计(比如把3D饼图换成条形图,把Y轴起点改回0),其成本几乎为零。因此,可视化陷阱的边际成本,可以用一个公式粗略表示:决策失误的潜在损失 / 修正设计的成本 ≈ ∞。

不仅如此,长期使用不规范、有误导性的图表,会逐渐侵蚀整个组织的数据素养和文化。大家会习惯于从图表中寻找自己想要的“证据”,而不是客观的事实。这比任何一次性的决策失误都更可怕,因为它动摇了企业数据驱动的根基。因此,在运营报表时,建立一套统一、规范的数据可视化标准(DV Guideline)是性价比极高的投资。它能以极低的成本,系统性地规避掉大部分可视化陷阱,为所有决策上一道“安全锁”。

常见可视化陷阱及其成本

| 陷阱类型 | 表现形式 | 导致的决策风险 | 修正成本 |

|---|

| 滥用饼图/环图 | 分类过多(>5类)或使用3D效果 | 无法准确比较各部分占比,误判业务结构 | 极低(更换为条形图) |

| 截断的Y轴 | 纵坐标不从0开始,夸大变化幅度 | 对增长或下降反应过度,造成战略冒进或保守 | 极低(调整坐标轴设置) |

| 双轴图误导 | 两条刻度范围差异巨大的曲线放在一起,暗示虚假的因果关系 | 强行关联不相关的两个指标,得出错误结论 | 中等(拆分为两个图或进行归一化处理) |

六、为何报表工程师的决策影响力能超越分析师?

这是一个可能会颠覆很多人传统认知的观点。通常我们认为,数据分析师是产出洞察、影响决策的人,而报表工程师只是实现需求的“工具人”。但在现代数据栈环境下,一个顶尖的报表工程师,其决策影响力完全可能超越一个普通的数据分析师。原因何在?关键在于“规模化赋能”的成本效益。

一个数据分析师,一次只能做一个分析,服务一个业务方或一个决策。他的产出是一份分析报告。而一个优秀的报表工程师,他思考的不是“如何回答这个业务问题”,而是“如何打造一个工具或一个系统,让100个业务人员都能自己回答这类问题”。他通过巧妙的报表设计、高效的数据建模和人性化的交互体验,将分析能力“产品化”,赋能给整个组织。比如,他设计了一个自助式的归因分析报表,市场部的每个员工都可以用它来分析自己渠道的投放效果,而不再需要每周都来找分析师提需求。

从成本效益来看,分析师的工作是线性的,成本和产出成正比。而报表工程师的工作是非线性的,他投入一次性的开发成本,构建了一个“分析能力放大器”,后续的边际成本几乎为零,但创造的价值却随着使用人数的增加而指数级增长。这正是SaaS模式的精髓。更深一层看,当报表工程师开始思考“如何让报表更好用”、“如何让数据更容易被理解”时,他已经从一个技术实现者,转变为一个用户体验设计师和业务赋能者。他的每一个设计决策,都在潜移默化地影响着成百上千人的日常工作和决策方式。这种系统性的、规模化的影响力,是单个分析报告难以企及的。因此,企业在做经营分析报告策划时,应当高度重视报表工程师的培养和选拔,他们是数据驱动战略能否低成本落地的关键支点。本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

.png)