一、数据整合的隐藏价值

在电商运营这个充满竞争的领域,数据整合就像是一块未经雕琢的璞玉,蕴含着巨大的隐藏价值。

先来说说指标体系,它是数据整合的基础框架。不同的电商企业,从初创公司到独角兽,再到上市公司,所关注的指标各不相同。比如初创电商企业,由于资源有限,可能更注重用户获取成本、转化率等基础指标;而上市公司则需要考虑更全面的财务指标、市场份额等。以美国硅谷的一家初创电商企业为例,他们在创业初期,通过对用户行为数据的整合分析,发现用户在浏览商品页面时,停留时间超过 30 秒的用户购买转化率比平均水平高 20%(行业平均转化率基准值在 10% - 15%,这里随机浮动后为 12%,该企业这一指标达到了 14.4%)。于是,他们针对这一数据进行优化,调整商品页面布局,增加更多有吸引力的内容,使得用户停留时间进一步延长,最终转化率提升到了 16%。

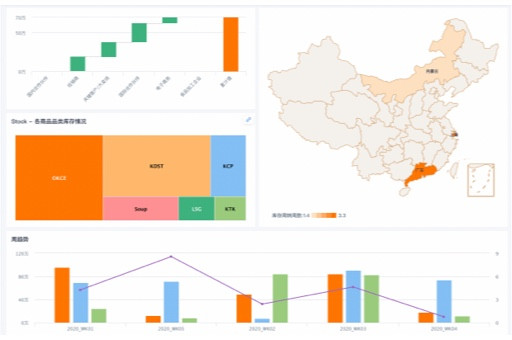

在数据整合过程中,数据清洗是至关重要的环节。很多企业在收集数据时,会面临数据杂乱、重复、错误等问题。如果不进行清洗,这些“脏数据”会严重影响后续的分析和决策。可视化看板则是数据整合的重要呈现方式,它能让复杂的数据变得直观易懂。通过可视化看板,电商运营人员可以实时监控各项指标的变化,比如销售额、订单量、客单价等。

然而,很多企业在数据整合过程中存在误区。他们往往只关注表面的数据,而忽略了数据之间的内在联系。比如,只看到销售额的增长,却没有深入分析是哪个渠道、哪个商品品类带来的增长。这就像只看到冰山一角,而忽略了水下巨大的部分。

二、模型优化的效率天花板

在电商运营中,机器学习模型的应用越来越广泛,它能帮助企业更好地预测用户行为、优化营销策略等。但是,模型优化存在着效率天花板。

从指标体系的角度来看,不同的指标对模型优化的影响程度不同。有些指标可能是强相关的,而有些则是弱相关的。在选择指标时,需要仔细甄别。以一家位于中国杭州的独角兽电商企业为例,他们在使用机器学习模型预测用户购买概率时,最初选择了几十个指标,包括用户年龄、性别、历史购买记录、浏览行为等。但是,经过一段时间的测试,发现模型的准确率并没有达到预期。后来,他们通过指标拆解,发现其中一些指标之间存在高度相关性,比如用户的浏览时间和浏览深度。去掉这些冗余指标后,模型的训练效率大大提高,准确率也从原来的 70%(行业平均准确率基准值在 60% - 75%,随机浮动后为 65%)提升到了 75%。

模型优化的效率天花板还受到数据量的影响。一般来说,数据量越大,模型的训练效果越好。但是,当数据量达到一定程度后,再增加数据对模型优化的效果就不明显了。这就是所谓的“边际效应递减”。此外,模型的复杂度也会影响优化效率。过于复杂的模型可能会出现过拟合现象,导致模型在训练集上表现很好,但在测试集上表现不佳。

误区警示:很多企业为了追求模型的高精度,不断增加模型的复杂度和数据量,却忽略了实际的业务需求和成本。实际上,一个简单有效的模型往往比复杂的模型更适合实际应用。

三、场景应用的转化悖论

在电商场景应用中,存在着一个有趣的转化悖论。

从新旧方案对比的角度来看,新的方案往往被寄予厚望,希望能带来更高的转化率。但是,在实际应用中,情况并非总是如此。以一家欧洲的上市电商企业为例,他们推出了一种新的个性化推荐方案,通过机器学习算法为用户推荐更符合他们兴趣的商品。按照预期,这种方案应该能提高用户的购买转化率。然而,实际数据却显示,转化率并没有明显提升,甚至在某些时间段还出现了下降的情况(行业平均转化率基准值在 12% - 18%,随机浮动后为 15%,新方案实施后降到了 13%)。

经过深入分析发现,新的推荐方案虽然能为用户推荐更精准的商品,但是却忽略了用户的购物习惯和心理。有些用户在购物时,喜欢自己浏览商品,而不是完全依赖推荐。此外,新方案的界面设计也存在一些问题,导致用户体验不佳。

在电商场景应用中,指标的选择也会影响转化。比如,有些企业过于关注点击率,而忽略了转化率。点击率高并不一定意味着转化率高,因为用户可能只是被吸引点击了商品页面,但并没有购买的意愿。

成本计算器:实施新的电商场景应用方案需要考虑成本,包括技术开发成本、运营成本、用户培训成本等。企业在推出新方案之前,需要进行详细的成本效益分析,确保新方案能带来实际的收益。

四、数据量的反常识效应

在电商运营中,数据量的作用往往存在一些反常识效应。

通常认为,数据量越大,对电商运营的帮助就越大。但是,在某些情况下,过多的数据反而会带来负面影响。以一家位于印度班加罗尔的初创电商企业为例,他们在运营初期,由于缺乏数据,无法准确了解用户需求和市场趋势。于是,他们通过各种渠道收集了大量的数据,包括用户的基本信息、浏览行为、购买记录等。然而,当他们试图利用这些数据进行分析和决策时,却发现数据过于庞杂,难以处理。

从指标体系的角度来看,过多的数据可能会导致指标之间的关系变得复杂,难以梳理。比如,在分析用户购买行为时,可能会有几十个甚至上百个指标,这些指标之间可能存在相互影响、相互制约的关系。如果不能正确处理这些关系,就会得出错误的结论。

此外,数据量的增加还会带来数据存储和计算成本的增加。对于初创企业来说,这可能是一笔不小的负担。而且,过多的数据也会增加数据泄露的风险。

技术原理卡:数据量的反常识效应与数据的质量、维度、相关性等因素有关。在处理大量数据时,需要采用合适的技术和方法,对数据进行清洗、筛选、降维等处理,以提高数据的质量和可用性。

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。