在如今的数据驱动时代,Hive数据仓库架构在各个行业中扮演着至关重要的角色。对于企业来说,选择合适的Hive数据仓库架构是一项关键决策。

首先,我们来了解一下Hive数据仓库架构的基本组成。它主要包括数据存储层、数据处理层和数据访问层。数据存储层通常使用Hadoop分布式文件系统(HDFS)来存储大规模的数据。HDFS具有高可靠性和高扩展性,能够满足企业对海量数据存储的需求。数据处理层则是Hive的核心部分,它通过MapReduce等计算框架对数据进行处理和分析。MapReduce是一种分布式计算模型,能够将大规模的数据处理任务分解成多个小任务,并在集群中的多个节点上并行执行,从而提高数据处理的效率。数据访问层提供了多种接口,如HiveQL、JDBC/ODBC等,方便用户对数据进行查询和分析。

在选择Hive数据仓库架构时,企业需要考虑多个因素。首先是数据量和数据增长速度。如果企业的数据量较大且增长速度较快,那么需要选择具有高扩展性的架构,以满足未来的数据存储和处理需求。其次是数据处理的复杂性。如果企业需要进行复杂的数据处理和分析,如数据挖掘、机器学习等,那么需要选择支持这些功能的架构。此外,企业还需要考虑成本、性能、可靠性等因素。

以电商场景为例,Hive数据仓库架构在电商行业中得到了广泛的应用。电商企业通常拥有大量的用户数据、交易数据和商品数据,这些数据对于企业的运营和决策至关重要。通过使用Hive数据仓库架构,电商企业可以对这些数据进行存储、处理和分析,从而实现精准营销、个性化推荐、库存管理等功能。例如,电商企业可以通过对用户的购买历史、浏览记录等数据进行分析,了解用户的兴趣和偏好,从而为用户推荐个性化的商品。

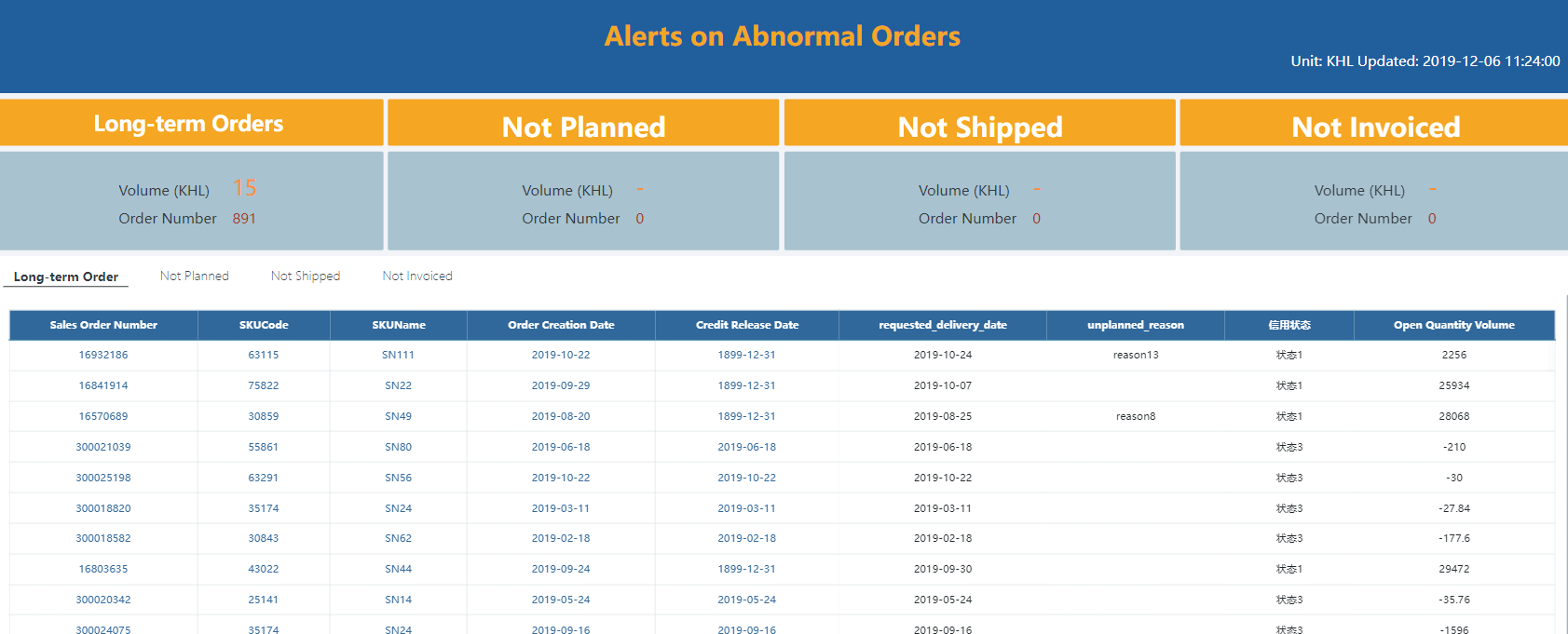

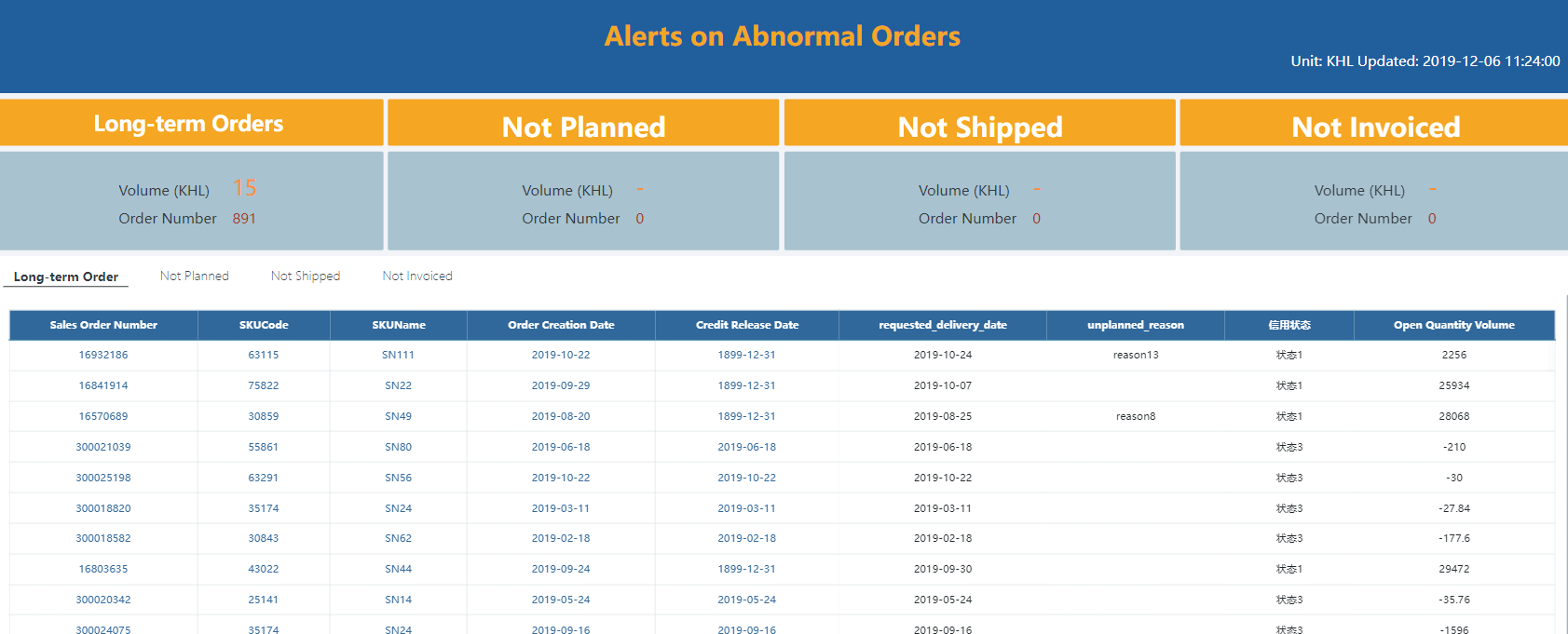

在金融风控领域,Hive数据仓库架构也发挥着重要的作用。金融机构需要对大量的客户数据、交易数据和风险数据进行分析和处理,以识别和评估风险。通过使用Hive数据仓库架构,金融机构可以对这些数据进行实时监控和分析,及时发现和预警风险。例如,金融机构可以通过对客户的信用记录、还款能力等数据进行分析,评估客户的信用风险,从而决定是否给予贷款。

二、MapReduce

MapReduce是Hive数据仓库架构中的核心计算框架,它在数据处理和分析中发挥着重要的作用。

MapReduce的基本思想是将大规模的数据处理任务分解成多个小任务,并在集群中的多个节点上并行执行。具体来说,MapReduce将输入数据分成多个数据块,每个数据块由一个Map任务处理。Map任务将输入数据转换为键值对形式,并将键值对发送给Reduce任务。Reduce任务对键值对进行聚合和处理,最终生成输出结果。

MapReduce的优点在于它能够充分利用集群的计算资源,提高数据处理的效率。通过将数据处理任务分解成多个小任务,并在多个节点上并行执行,MapReduce能够在较短的时间内处理大规模的数据。此外,MapReduce还具有高可靠性和高扩展性,能够适应不同规模和复杂度的数据处理任务。

在实际应用中,MapReduce被广泛应用于各种数据处理和分析场景。例如,在电商场景中,MapReduce可以用于对用户的购买历史、浏览记录等数据进行分析,从而实现精准营销、个性化推荐等功能。在金融风控领域,MapReduce可以用于对客户的信用记录、还款能力等数据进行分析,评估客户的信用风险。

然而,MapReduce也存在一些缺点。首先,MapReduce的编程模型相对复杂,需要开发人员具备一定的编程经验和技能。其次,MapReduce的性能受到网络带宽和磁盘I/O等因素的影响,在处理大规模数据时可能会出现性能瓶颈。此外,MapReduce的容错性相对较差,在节点故障时可能会导致任务失败。

为了解决MapReduce的缺点,近年来出现了一些新的计算框架,如Spark、Flink等。这些计算框架在性能、易用性和容错性等方面都有了很大的提升,逐渐成为了MapReduce的替代品。

三、金融风控

金融风控是金融机构面临的重要挑战之一,它涉及到对客户的信用风险、市场风险、操作风险等进行识别、评估和控制。在金融风控领域,Hive数据仓库架构和MapReduce等技术发挥着重要的作用。

首先,Hive数据仓库架构可以帮助金融机构存储和管理大量的客户数据、交易数据和风险数据。通过使用Hive数据仓库架构,金融机构可以将这些数据集中存储在一个统一的平台上,方便进行数据的查询、分析和处理。此外,Hive数据仓库架构还支持数据的实时更新和增量加载,能够满足金融机构对数据实时性的要求。

其次,MapReduce等计算框架可以帮助金融机构对大量的数据进行处理和分析,从而识别和评估风险。通过使用MapReduce等计算框架,金融机构可以对客户的信用记录、还款能力等数据进行分析,评估客户的信用风险。此外,MapReduce等计算框架还可以对市场数据、交易数据等进行分析,识别市场风险和操作风险。

在实际应用中,金融机构通常会结合使用Hive数据仓库架构和MapReduce等计算框架,构建一个完整的金融风控系统。例如,金融机构可以使用Hive数据仓库架构存储和管理客户数据、交易数据和风险数据,使用MapReduce等计算框架对这些数据进行处理和分析,从而识别和评估风险。此外,金融机构还可以使用机器学习、数据挖掘等技术,对风险数据进行预测和分析,提高风险评估的准确性和可靠性。

然而,金融风控系统的建设和维护是一项复杂的任务,需要金融机构具备一定的技术实力和管理能力。在建设金融风控系统时,金融机构需要考虑多个因素,如数据质量、数据安全、系统性能、系统可靠性等。此外,金融机构还需要不断地对金融风控系统进行优化和升级,以适应不断变化的市场环境和业务需求。

四、数据采集

数据采集是构建Hive数据仓库架构的步,它涉及到从各种数据源中收集数据,并将数据传输到Hive数据仓库中。在电商场景下,数据采集的数据源通常包括网站日志、交易系统、用户行为数据等。在金融风控领域,数据采集的数据源通常包括客户信息、交易记录、信用评级等。

数据采集的方法有很多种,常见的方法包括手动采集、自动采集和批量采集。手动采集是指通过人工的方式从数据源中收集数据,这种方法适用于数据量较小、数据更新频率较低的情况。自动采集是指通过编写脚本或使用数据采集工具,自动从数据源中收集数据,这种方法适用于数据量较大、数据更新频率较高的情况。批量采集是指将数据按照一定的时间间隔或数据量进行分批采集,这种方法适用于数据量较大、数据更新频率较低的情况。

在选择数据采集方法时,企业需要考虑多个因素,如数据量、数据更新频率、数据质量、数据安全等。此外,企业还需要考虑数据采集的成本和效率,选择最适合自己的数据采集方法。

在实际应用中,数据采集通常需要经过多个步骤,包括数据清洗、数据转换、数据加载等。数据清洗是指对采集到的数据进行去重、纠错、补全等处理,以提高数据的质量。数据转换是指将采集到的数据转换为Hive数据仓库所支持的格式,以便进行数据的存储和处理。数据加载是指将转换后的数据加载到Hive数据仓库中,以便进行数据的查询和分析。

五、数据清洗

数据清洗是构建Hive数据仓库架构的重要环节,它涉及到对采集到的数据进行去重、纠错、补全等处理,以提高数据的质量。在电商场景下,数据清洗的目的是为了确保用户数据、交易数据和商品数据的准确性和完整性。在金融风控领域,数据清洗的目的是为了确保客户信息、交易记录和信用评级的准确性和可靠性。

数据清洗的方法有很多种,常见的方法包括数据过滤、数据转换、数据验证等。数据过滤是指通过编写脚本或使用数据清洗工具,对采集到的数据进行筛选和过滤,以去除无效数据和重复数据。数据转换是指将采集到的数据转换为Hive数据仓库所支持的格式,以便进行数据的存储和处理。数据验证是指对采集到的数据进行验证和检查,以确保数据的准确性和完整性。

在选择数据清洗方法时,企业需要考虑多个因素,如数据量、数据质量、数据安全等。此外,企业还需要考虑数据清洗的成本和效率,选择最适合自己的数据清洗方法。

在实际应用中,数据清洗通常需要经过多个步骤,包括数据预处理、数据清洗、数据验证等。数据预处理是指对采集到的数据进行初步处理,如数据格式转换、数据编码转换等。数据清洗是指对预处理后的数据进行去重、纠错、补全等处理,以提高数据的质量。数据验证是指对清洗后的数据进行验证和检查,以确保数据的准确性和完整性。

六、数据建模

数据建模是构建Hive数据仓库架构的核心环节,它涉及到对数据进行分析和建模,以建立数据之间的关系和模型。在电商场景下,数据建模的目的是为了建立用户行为模型、商品推荐模型、库存管理模型等。在金融风控领域,数据建模的目的是为了建立信用风险模型、市场风险模型、操作风险模型等。

数据建模的方法有很多种,常见的方法包括数据挖掘、机器学习、统计分析等。数据挖掘是指通过对大量数据进行分析和挖掘,发现数据之间的关系和规律,以建立数据模型。机器学习是指通过对大量数据进行学习和训练,建立模型并进行预测和分类。统计分析是指通过对数据进行统计分析,建立数据模型并进行预测和推断。

在选择数据建模方法时,企业需要考虑多个因素,如数据量、数据质量、数据安全等。此外,企业还需要考虑数据建模的成本和效率,选择最适合自己的数据建模方法。

在实际应用中,数据建模通常需要经过多个步骤,包括数据准备、数据探索、数据建模、模型评估等。数据准备是指对采集到的数据进行清洗、转换、集成等处理,以提高数据的质量和可用性。数据探索是指对准备好的数据进行探索和分析,以发现数据之间的关系和规律。数据建模是指根据数据探索的结果,选择合适的数据建模方法,建立数据模型。模型评估是指对建立好的数据模型进行评估和验证,以确保模型的准确性和可靠性。

---

误区警示:在选择Hive数据仓库架构时,企业需要注意避免一些常见的误区。首先,企业需要避免过度依赖Hive数据仓库架构,而忽略了其他数据处理和分析工具的应用。其次,企业需要避免盲目追求高性能和高扩展性,而忽略了成本和效率的考虑。此外,企业还需要避免忽视数据质量和数据安全的问题,而导致数据处理和分析的结果不准确和不可靠。

成本计算器:为了帮助企业更好地了解Hive数据仓库架构的成本,我们提供了一个成本计算器。通过输入数据量、数据更新频率、数据处理复杂度等参数,成本计算器可以帮助企业估算Hive数据仓库架构的建设和维护成本。

技术原理卡:Hive数据仓库架构是基于Hadoop分布式文件系统(HDFS)和MapReduce计算框架构建的。HDFS是一种分布式文件系统,它能够将大规模的数据存储在多个节点上,并提供高可靠性和高扩展性。MapReduce是一种分布式计算模型,它能够将大规模的数据处理任务分解成多个小任务,并在集群中的多个节点上并行执行,从而提高数据处理的效率。

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。