数据处理清洗是一个至关重要的过程,尤其在信息爆炸的时代。我们每天都在接触大量的数据,但这些数据往往杂乱无章,充满了错误和缺失值。因此,进行数据处理清洗就显得尤为重要。它不仅能提高数据质量,还能确保我们从中提取出有价值的信息。

为什么需要进行数据处理清洗?

原始数据往往包含很多错误,比如重复记录、缺失值等。这就好比你在网上购物时,如果看到同一件商品出现了三次,你肯定会感到困惑,对吧?通过数据处理清洗,我们可以消除这些干扰因素,让我们的分析更加顺畅。随着时间的推移,数据也会发生变化。有时候,我们收集的数据可能已经过时了,就像旧手机一样,不再适合现在的需求。因此,我们需要定期对这些数据进行更新和维护,以保证它们的有效性。

如何进行有效的数据处理清洗?

有效的数据处理清洗可以使用一些工具来帮助我们,比如Python中的Pandas库,它就像是一位优秀的助手,可以快速帮我们完成繁琐的任务。此外,还有许多开源软件可供选择,如OpenRe等,这些工具都能大大提高我们的工作效率。在进行数据处理清洗时,也要注意不要过度“修饰”我们的数据。就像化妆一样,一点点修饰可以让人焕然一新,但如果涂得太厚,就可能适得其反。因此,在这个过程中,要保持一定的原则性和灵活性。

常见的数据处理清洗方法

接下来,让我们聊聊一些常见的数据处理清洗方法吧!去重是一个重要步骤,就像是在派对上找朋友,如果发现某个人重复出现,那肯定要把他请出去!填补缺失值可以通过平均值、中位数等方式来实现,就像是在拼图游戏中,把缺失的部分补齐,让整体看起来更完整。还有一种方法就是标准化,将不同格式的数据统一为一种格式。这就好比是在不同国家旅行时,为了方便交流,需要学习几句当地语言。而最后一步,就是验证和测试,以确保我们的“作品”没有问题,可以放心使用。

数据处理清洗与高效数据管理技巧

数据分析师、数据工程师与数据科学家的视角

说实话,数据处理清洗在当今的数字化时代变得越来越重要。作为一名数据分析师,我常常发现,数据的质量直接影响到分析结果的准确性和可靠性。让我们来想想,假设我们有一堆数据,但其中包含了大量的错误和缺失值,这样的情况下,我们的分析结果会有什么意义呢?

数据工程师在这个过程中扮演着至关重要的角色。他们负责构建和维护数据管道,确保数据在流动过程中不会丢失或被篡改。大家都想知道,数据工程师通常会使用一些自动化工具来进行数据清洗,比如Apache Spark和Talend等。这些工具能够帮助他们快速识别和修复数据中的问题,从而提高数据的质量。

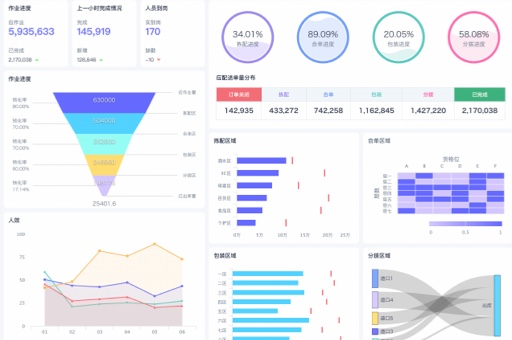

而数据科学家则更关注于如何利用清洗后的数据进行深度分析和建模。让我们先来思考一个问题,如何确保我们所使用的数据是高质量的?数据科学家通常会在数据清洗的过程中,进行数据的可视化分析,帮助他们更好地理解数据的分布和特征。根据我的了解,数据清洗不仅仅是一个技术问题,更是一个策略问题,涉及到如何制定合理的数据管理规范。

数据质量的重要性

让我们来想想,数据质量到底有多重要?在很多企业中,数据被视为“新石油”,而数据质量则是这“石油”的提炼过程。说实话,只有高质量的数据才能为企业提供有价值的洞察和决策支持。根据我的了解,数据质量主要包括准确性、完整性、一致性、及时性和唯一性等几个方面。

首先,准确性是数据质量的核心。如果数据不准确,那么无论我们如何分析,结果都可能是错误的。比如说,假设我们在分析客户的购买行为时,数据中有一部分客户的年龄信息是错误的,这样的情况下,我们的分析结果就会受到影响,甚至导致错误的市场决策。

其次,完整性也是数据质量的重要指标。如果数据中缺少了关键字段,比如客户的联系方式,那么我们在进行市场推广时就无法有效地联系到目标客户。大家都想知道,如何确保数据的完整性呢?通常,企业会在数据录入时设置一些必要字段,确保每条数据都能完整记录。

一致性和及时性同样重要。一致性指的是同一数据在不同系统中的表现应该是相同的,而及时性则是指数据需要在适当的时间内被更新和使用。如果数据过时,那么它的价值也会大打折扣。因此,企业需要建立有效的数据更新机制,确保数据的时效性。

最后,唯一性是指数据中不应该存在重复的记录。重复数据不仅会浪费存储空间,还会导致分析结果的偏差。为了确保数据的唯一性,企业通常会在数据录入时进行去重处理。总之,只有确保高质量的数据才能为后续的分析和决策提供可靠支持。

数据处理清洗的技术与工具

大家都想知道,随着数据量不断增加,传统手动清洗方法已经无法满足需求。现在很多企业开始采用自动化的数据清洗工具来提高效率。Python和R是最常用的编程语言,它们提供了丰富的数据处理库,比如Pandas和dplyr。这些库能够帮助快速进行清洗和转换,提高工作效率。此外,Python的Scikit-learn库也提供了一些预处理功能,比如缺失值填充和标准化等。

ETL(提取、转换、加载)工具在此过程中也扮演着重要角色,如Apache Nifi、Talend和Informatica等ETL工具能够帮助企业自动化提取和转换过程,从而减少人工干预,提高效率。同时,可视化工具如Tableau和Power BI也能发挥作用,通过可视化分析帮助发现异常值和缺失值,从而及时处理。最后,监控工具如Great Expectations和DataRobot等,可以实时监测质量,以确保准确性和完整性。

本文编辑:小科,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。