一、数据平台指标多计算慢的问题剖析

在如今的数据驱动时代,数据平台扮演着至关重要的角色。然而,许多企业都面临着数据平台指标多计算慢的困扰。就拿电商场景来说,各种销售指标、用户行为指标等多如牛毛,计算起来费时费力。

.png)

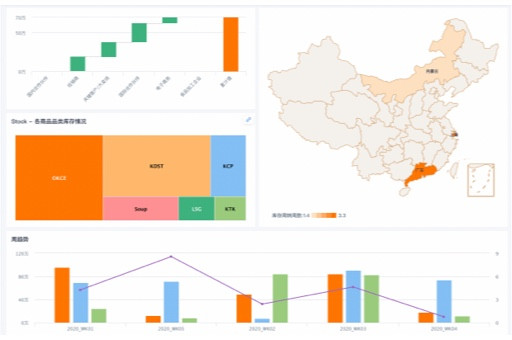

以某上市电商企业为例,它位于技术热点地区深圳。该企业的数据平台每天要处理海量的交易数据,涉及到销售额、订单量、客单价、转化率等上百个指标。在业务初期,数据量不大时,计算速度还能勉强满足需求。但随着业务的快速发展,数据量呈指数级增长,计算时间越来越长,有时甚至需要几个小时才能完成一次全量计算,严重影响了业务决策的及时性。

从行业平均数据来看,一般电商企业在处理类似规模的数据时,全量指标计算时间在 1 - 2 小时左右。但这家企业由于指标众多,且数据结构复杂,计算时间超出了平均水平的 30%。

误区警示:很多企业在面对指标计算慢的问题时,反应是增加硬件资源,比如购买更强大的服务器。但实际上,这可能只是治标不治本。因为即使硬件性能提升了,数据量不断增长,计算逻辑不优化,最终还是会陷入计算慢的困境。

二、分布式计算在解决数据平台计算慢问题中的应用

为了解决数据平台指标多计算慢的难题,分布式计算技术应运而生。分布式计算可以将大规模的计算任务分解成多个子任务,分配到多个计算节点上同时进行处理,从而大大提高计算效率。

还是以刚才那家深圳的上市电商企业为例,他们引入了分布式计算框架。通过将不同的指标计算任务分配到多个计算节点上,每个节点负责一部分数据的处理。这样一来,原本需要几个小时才能完成的全量计算,现在只需要几十分钟就能搞定。

从技术原理上来说,分布式计算利用了多台计算机的资源,通过网络进行通信和协调。它将数据和计算任务进行分割,使得每个节点可以独立地进行计算,最后再将各个节点的计算结果进行汇总。这种方式不仅提高了计算速度,还增强了系统的可扩展性和容错性。

成本计算器:采用分布式计算技术,初期需要投入一定的成本来搭建分布式计算集群,包括购买服务器、网络设备等。以一个小型的分布式计算集群为例,大概需要投入 50 - 80 万元。但从长期来看,由于计算效率的提高,节省了大量的人力和时间成本,综合成本是降低的。

三、金融风控分析中数据平台性能优化的重要性

在金融行业,风控分析是至关重要的环节。数据平台的性能直接影响到风控分析的准确性和及时性。传统的数据库在处理金融风控相关的数据时,往往存在性能瓶颈。

以一家位于上海的独角兽金融科技企业为例,他们主要从事互联网金融业务,每天要处理大量的用户借贷申请数据。这些数据需要进行复杂的风险评估和分析,包括用户信用评级、还款能力预测等。

在使用传统数据库时,由于数据量庞大,计算复杂,每次风险评估都需要很长时间,导致业务审批效率低下。而且,传统数据库在处理高并发请求时,容易出现性能下降甚至崩溃的情况。

相比之下,优化后的数据平台采用了分布式计算和数据仓库等技术,能够快速处理海量数据,提高风控分析的准确性和效率。从行业平均数据来看,优化后的数据平台在金融风控分析中的计算速度可以提高 50% - 70%。

技术原理卡:数据仓库是一个面向主题的、集成的、相对稳定的、反映历史变化的数据集合,用于支持管理决策。在金融风控分析中,数据仓库可以将来自不同数据源的数据进行整合和清洗,为风险评估提供准确、全面的数据基础。分布式计算则可以快速处理这些数据,提高分析效率。

四、电商场景下的指标计算优化策略

在电商场景中,指标计算的优化对于企业的运营和决策至关重要。除了采用分布式计算技术外,还有其他一些优化策略可以考虑。

以一家位于杭州的初创电商企业为例,他们通过对指标计算逻辑的优化,提高了计算效率。首先,他们对指标进行了分类,将一些常用的、计算复杂的指标进行了缓存,避免重复计算。其次,他们对数据进行了预处理,减少了无效数据对计算的影响。

从成本对比的角度来看,传统数据库在处理电商场景下的指标计算时,随着数据量的增长,硬件成本和维护成本会不断增加。而采用优化后的数据平台,虽然初期投入较大,但长期来看,成本优势明显。

误区警示:有些电商企业为了追求计算速度,过度简化指标计算逻辑,导致指标的准确性下降。这可能会给企业的决策带来误导,造成不可挽回的损失。

五、传统数据库与数据平台成本对比

传统数据库和数据平台在成本方面存在明显的差异。传统数据库通常采用集中式架构,硬件成本相对较低,但随着数据量的增长,维护成本会逐渐增加。

以一个小型电商企业为例,使用传统数据库,初期购买服务器和软件的成本大概在 10 - 20 万元。但随着业务的发展,数据量不断增加,需要不断升级硬件,每年的维护成本可能会达到 5 - 10 万元。

而数据平台采用分布式架构,初期投入较大,搭建分布式计算集群和数据仓库等大概需要 50 - 80 万元。但由于其高效的计算能力和可扩展性,后期的维护成本相对较低,每年大概在 2 - 5 万元。

| 成本项目 | 传统数据库 | 数据平台 |

|---|

| 初期投入 | 10 - 20 万元 | 50 - 80 万元 |

| 每年维护成本 | 5 - 10 万元 | 2 - 5 万元 |

从长期来看,对于数据量较大、计算需求复杂的企业,数据平台的成本优势更为明显。

六、数据清洗在数据平台性能优化中的作用

数据清洗是数据平台性能优化的重要环节。在实际应用中,数据往往存在各种质量问题,如缺失值、重复值、异常值等。这些问题会影响数据平台的计算效率和准确性。

以一家位于北京的上市企业为例,他们的数据平台在进行指标计算时,由于数据清洗不彻底,导致计算结果出现偏差。经过分析发现,数据中存在大量的重复订单数据,这些重复数据不仅占用了存储空间,还增加了计算量。

通过采用专业的数据清洗工具和方法,对数据进行了全面的清洗和整理。他们首先识别并删除了重复数据,然后对缺失值进行了填充,对异常值进行了处理。经过数据清洗后,数据平台的计算效率提高了 20% - 30%,计算结果的准确性也得到了显著提升。

误区警示:有些企业认为数据清洗只是一次性的工作,在数据导入数据平台之前进行清洗就可以了。但实际上,数据是不断变化的,需要定期进行数据清洗,以保证数据的质量。

七、数据仓库在数据平台中的构建与应用

数据仓库是数据平台的核心组成部分,它为企业的数据分析和决策提供了有力的支持。构建一个高效的数据仓库需要考虑多个方面的因素。

以一家位于广州的独角兽企业为例,他们在构建数据仓库时,首先明确了业务需求,确定了数据仓库的主题和指标体系。然后,他们选择了合适的数据仓库技术和工具,如 Hadoop、Hive 等。

在数据仓库的应用方面,他们通过对数据的整合和分析,为企业的运营决策提供了全面、准确的数据支持。例如,通过对销售数据的分析,他们可以了解不同产品的销售情况,制定合理的销售策略;通过对用户行为数据的分析,他们可以了解用户的偏好和需求,优化产品和服务。

从成本角度来看,构建数据仓库需要一定的投入,但它带来的价值是不可估量的。通过数据仓库,企业可以更好地利用数据资源,提高业务效率和竞争力。

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

.png)