一、数据孤岛造成的价值流失

在当今数字化时代,数据孤岛问题就像一个个信息的“孤岛”,阻碍着企业充分挖掘数据的潜在价值。对于BI系统来说,数据孤岛是一个亟待解决的难题。

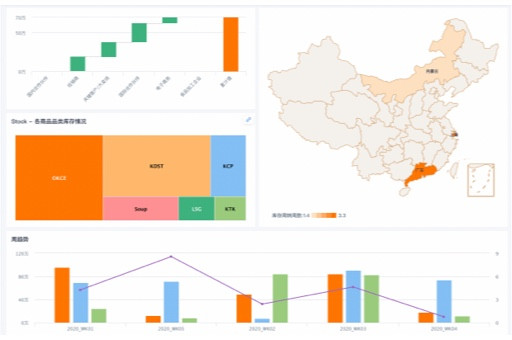

以零售业销售预测为例,企业可能拥有来自不同渠道的数据,如线上电商平台、线下门店的销售数据,还有库存数据、客户数据等。这些数据分散在不同的系统中,形成了数据孤岛。比如一家上市的零售企业,其线上销售数据存储在电商平台的数据库中,线下门店的销售数据则存储在各自的POS系统里。由于这些系统之间缺乏有效的数据共享机制,导致数据无法整合分析。

从数据仓库的角度看,数据孤岛使得数据仓库难以获取全面、准确的数据。数据仓库本应是企业数据的集中存储和管理中心,但如果存在数据孤岛,数据仓库中的数据就会不完整,无法为BI系统提供可靠的数据源。ETL工具在处理数据时,也会因为数据孤岛的存在而面临困难,需要花费大量的时间和精力来整合不同来源的数据。

数据孤岛造成的价值流失是巨大的。据统计,行业内由于数据孤岛问题导致的销售预测准确率下降幅度在15% - 30%之间。这意味着企业可能会因为不准确的销售预测而做出错误的决策,如库存积压或缺货,从而影响企业的运营效率和盈利能力。

误区警示:很多企业认为只要购买了先进的BI工具,就能解决数据孤岛问题。实际上,BI工具只是一个分析和展示数据的平台,要真正解决数据孤岛问题,需要从企业的整体架构和数据管理策略入手,建立统一的数据标准和数据共享机制。

二、实时分析技术的应用盲区

实时分析技术在BI系统中扮演着越来越重要的角色,但在实际应用中,仍然存在一些盲区。

在电商场景中,实时分析技术可以帮助企业及时了解市场动态和客户需求,从而做出快速响应。例如,一家位于硅谷的初创电商企业,希望通过实时分析技术来优化其产品推荐策略。然而,在实际应用中,他们发现实时分析技术存在一些问题。

首先,实时数据的质量难以保证。由于数据的产生和传输速度非常快,可能会出现数据丢失、错误或重复的情况。这就需要企业在数据采集和传输过程中采取有效的措施来保证数据的质量。

其次,实时分析技术对计算资源的要求非常高。要对大量的实时数据进行分析和处理,需要强大的计算能力和存储能力。这对于一些中小企业来说,可能是一个不小的挑战。

此外,实时分析技术在算法选择和模型训练方面也存在一些困难。不同的业务场景需要不同的算法和模型,而实时分析技术需要在短时间内对数据进行分析和预测,这就要求算法和模型具有较高的准确性和实时性。

从机器学习的角度看,实时分析技术需要不断地更新和优化模型,以适应不断变化的数据和业务需求。然而,模型的更新和优化需要一定的时间和计算资源,这就可能导致模型的准确性和实时性之间存在矛盾。

成本计算器:假设一家企业希望实施实时分析技术,需要考虑以下成本:硬件成本(服务器、存储设备等)、软件成本(实时分析工具、数据库等)、人力成本(数据工程师、分析师等)。根据行业经验,硬件成本可能在10万元 - 30万元之间,软件成本可能在5万元 - 15万元之间,人力成本可能在20万元 - 50万元之间。

三、业务场景与算法匹配的黄金比例

在BI系统中,业务场景与算法的匹配是非常重要的。不同的业务场景需要不同的算法,只有选择合适的算法,才能提高BI系统的分析和预测能力。

以零售业销售预测为例,不同的销售场景需要不同的算法。例如,对于季节性产品的销售预测,需要考虑季节因素的影响,可以使用时间序列分析算法。对于新产品的销售预测,由于缺乏历史数据,可以使用基于相似产品的预测算法。

在电商场景中,业务场景更加复杂,需要综合考虑多种因素,如客户行为、市场趋势、竞争对手等。这就需要选择更加复杂的算法,如机器学习算法。机器学习算法可以通过对大量数据的学习和分析,自动发现数据中的规律和模式,从而提高销售预测的准确性。

然而,并不是所有的业务场景都适合使用复杂的算法。对于一些简单的业务场景,使用简单的算法可能会更加有效。例如,对于一些周期性的销售预测,可以使用简单的移动平均算法。

从数据挖掘的角度看,业务场景与算法的匹配需要考虑数据的特点和质量。不同的数据特点和质量需要不同的算法,只有选择合适的算法,才能从数据中挖掘出有价值的信息。

技术原理卡:以时间序列分析算法为例,其基本原理是通过对历史数据的分析,发现数据中的趋势、季节性和周期性等规律,从而预测未来的数据。时间序列分析算法包括简单移动平均算法、加权移动平均算法、指数平滑算法等。

四、数据质量并非首要障碍

在BI系统的实施过程中,很多人认为数据质量是首要障碍。然而,实际上数据质量并非总是首要障碍。

在一些情况下,数据质量问题可能并不是最严重的问题。例如,在一些快速发展的行业,如电商行业,市场变化非常快,企业需要快速做出决策。在这种情况下,即使数据质量存在一些问题,企业也可能需要先进行分析和预测,然后再逐步提高数据质量。

此外,数据质量问题可以通过一些技术手段来解决。例如,可以使用数据清洗、数据集成、数据转换等技术来提高数据质量。这些技术可以帮助企业从大量的数据中筛选出有用的数据,并对数据进行处理和分析。

从机器学习的角度看,机器学习算法具有一定的容错能力,可以在一定程度上处理数据质量问题。例如,一些机器学习算法可以通过对数据的学习和分析,自动发现数据中的异常值和噪声,并对其进行处理。

然而,这并不是说数据质量不重要。数据质量是BI系统的基础,只有保证数据质量,才能提高BI系统的分析和预测能力。因此,企业在实施BI系统时,需要同时关注数据质量和业务需求,采取有效的措施来提高数据质量。

案例:一家位于纽约的独角兽企业,在实施BI系统时,发现数据质量存在一些问题。然而,由于市场竞争激烈,企业需要快速做出决策。因此,企业决定先使用现有的数据进行分析和预测,然后再逐步提高数据质量。通过这种方式,企业成功地在市场竞争中取得了优势。

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。